Lass mich allein!

Viele verstehen unter dem Begriff „digitaler Zwilling“ nur eine Art Modell eines Bauwerks oder einer Maschine. Tatsächlich steckt sehr viel mehr dahinter. (© Juan Carlos Alonso Lopez/Shutterstock)

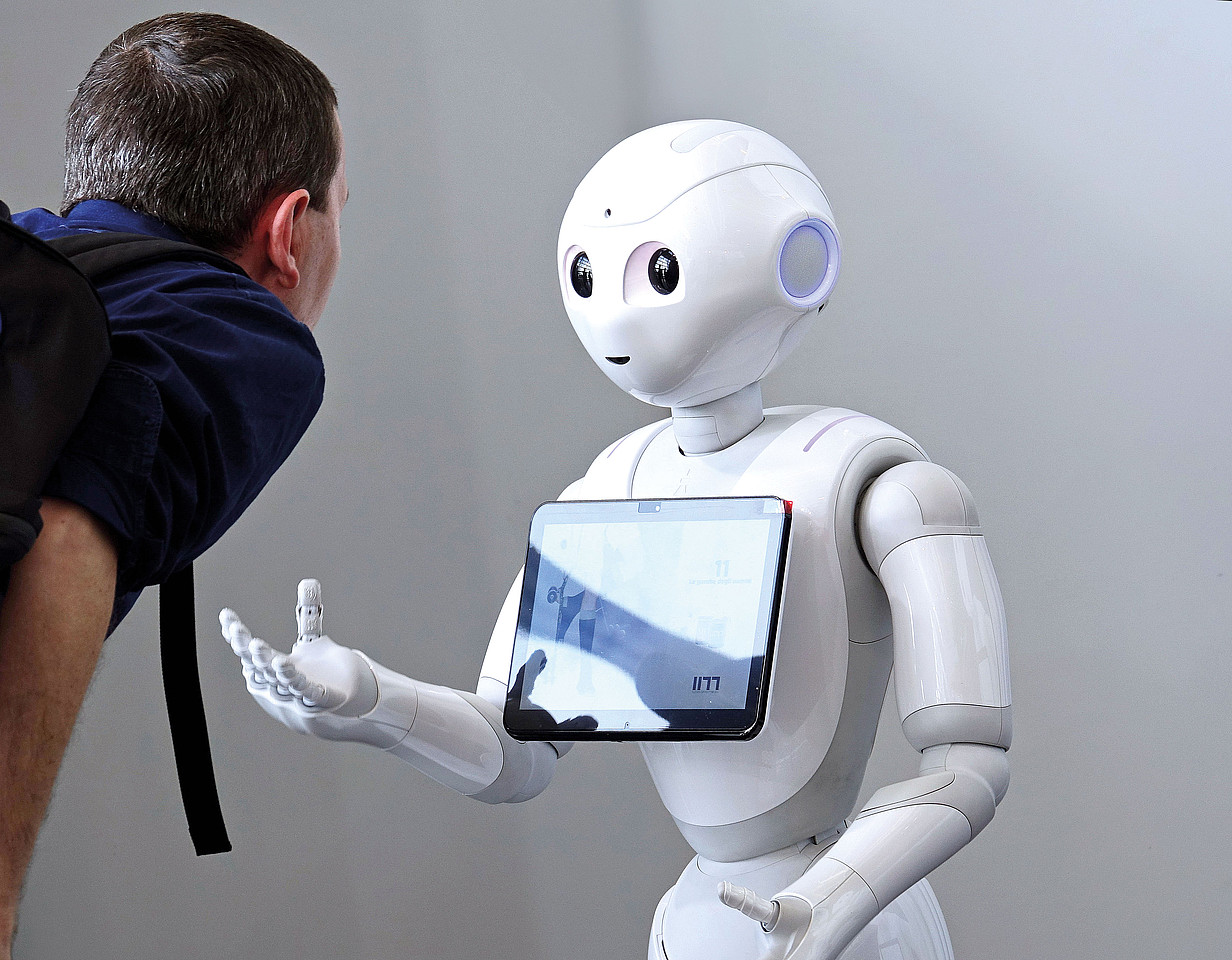

Sie heißen Pepper, Navel, Cruzr oder James und sind gern gesehene Gäste auf Messen und Branchen-Events: Mobile Roboter sehen nicht nur futuristisch aus, sondern können heutzutage auch vielseitig in unserem Alltag eingesetzt werden. Sie dienen als Hingucker und Möglichkeit, Digitalisierung greifbar zu machen, als Informationsquelle in öffentlichen Räumen wie Museen, Flughäfen und Hotels oder als physische Avatare für Kinder, die gerade nicht selbst zur Schule kommen können.

Auch als Assistenz für ältere Menschen können solche Roboter zum Einsatz kommen – und bringen einige Vorteile mit sich. So ermöglichen sie ihnen zum Beispiel, zu Hause in ihrer gewohnten Umgebung zu bleiben, und mindern gleichzeitig die Risiken der sozialen Isolation, indem sie sich mit ihnen unterhalten.1 Zudem können Roboter die älteren Menschen im Alltag unterstützen, indem sie sie etwa an die Einnahme ihrer Medikamente erinnern oder ihnen mittels Gelenkarmen helfen, Gegenstände zu greifen.

Um solche Funktionalitäten anzubieten, sind die Roboter mit verschiedenen Sensoren ausgestattet. So sammeln, verarbeiten, speichern und übertragen sie zahlreiche Daten über Personen in ihrer Nähe sowie über ihr Umfeld. Der Roboter Pepper2 zum Beispiel nutzt Mikrofone, um Geräusche und Sprache wahrzunehmen, sowie 3D-Kameras, um sich im Raum zu orientieren und das Zusammenstoßen mit Möbelstücken zu vermeiden. Zudem kann Pepper durch diese Sensoren auch Emotionen erkennen: Er analysiert Spracheingaben, Gesichtsausdrücke und Berührungen – und kann anhand von definierten Schwellenwerten die Laune – negativ, positiv oder unbekannt – sowie die Aufregung der Nutzer*innen – ruhig, aufgeregt, unbekannt – erkennen. Diese kann er im Anschluss gewissen Gefühlen zuordnen: von zufrieden über neutral, freudig, traurig bis hin zu verärgert.3

Damit Roboter etwa als Haushaltshilfe eingesetzt werden können, braucht es klare Regeln. (© Possesed Photography/unsplash)

Viele Daten über Gefühle und Gesundheit

Roboter können im Laufe ihres Einsatzes also sehr viele sensible Erkenntnisse gewinnen, etwa über die Gesundheitsprobleme, das Verhalten4, die Gefühle5 oder das emotionale Wohlbefinden der Nutzer*innen6. Darüber hinaus sammeln sie Informationen über das Wohnumfeld, in dem sie sich bewegen, einschließlich sichtbarer Objekte und Grundrisse.7 Dadurch können Informationen zum Beispiel über die Größe der Wohnung oder den Einrichtungsstil der Nutzer*innen abgeleitet werden.

Neben der Sammlung all dieser Daten können Roboter auch auf eine andere Art in die Privatsphäre ihrer Nutzer*innen eindringen: etwa, wenn sie einen zu geringen Abstand zu einer Person halten oder sie konstant anschauen.8 Wenn sie nicht entsprechend programmiert sind, kann es auch passieren, dass die Roboter den Nutzer*innen an Orte folgen, wo sie sich keine Begleitung wünschen, wie ins Schlafzimmer oder ins Badezimmer.9 Zudem besteht das Risiko, dass Roboter den Wunsch, in gewissen Situationen oder an bestimmten Orten alleine gelassen zu werden, nicht respektieren – hier braucht es klare Funktionen, die das verhindern.

Was weiß der Roboter?

Mittels einer Online-Befragung von mehr als tausend älteren Menschen haben wir erörtert, welche konkreten Wünsche die potenziellen Nutzer*innen an solche Roboter haben. Das Bedürfnis nach Privatsphäre hat sich dabei ganz klar bestätigt. Darüber hinaus zeigte sich, dass die Mehrheit der Teilnehmer*innen interessiert wäre, die Informationen, die über sie gesammelt wurden, zu sehen und zu überprüfen. Wie sich das jedoch möglichst benutzerfreundlich umsetzen lässt, bleibt noch zu erforschen.

Fest steht: Ohne geeignete Schutzmechanismen können Roboter die Privatheit ihrer Nutzer*innen gefährden – im informellen, physischen und sozialen Sinne.10 Abgesehen von den Gefährdungen, die vom Missbrauch der gesammelten Informationen ausgehen, und der Respektlosigkeit, die beim Überschreiten von physischen sowie sozialen Grenzen empfunden wird, kann dies weitere Konsequenzen haben. Es kommt vor, dass die betroffenen Personen ihr Verhalten in der Anwesenheit der Roboter verändern11, sich zum Beispiel direkt umdrehen oder den Raum verlassen, oder die Nutzung von Robotern komplett ablehnen.12

Verschiedene Forschungsteams haben bereits Richtlinien und Empfehlungen für das Design von Robotern erarbeitet, die die Privatsphäre ihrer Nutzer*innen respektieren, sowie praktische Lösungen, um diese zu implementieren. Diese variieren in ihrer Komplexität und reichen von einfachen Lichtsignalen, die auf eine Datensammlung hinweisen, oder physischen Knöpfen, um diese zu stoppen, bis hin zu anspruchsvollen technischen Lösungen, die zum Beispiel sensible Orte, Gesichter und Körper, Situationen oder eine Kombination von allen in den gesammelten Daten erkennen. Je nachdem, wie sie diese kategorisieren, schlagen sie verschiedene Lösungen vor, um die sensiblen Elemente auszublenden.

Auch wenn die existierenden Richtlinien und Empfehlungen eine gute Grundlage für das Design von privatheitsfreundlichen Robotern bilden: Sie bleiben theoretisch und müssen teilweise noch durch die Entwicklung von passenden Lösungen in die Praxis übertragen werden. Es gibt bereits einzelne Ansätze, doch es fehlt zurzeit noch an ganzheitlichen Lösungen, die verschiedene Dimensionen der Privatheit zeitgleich abdecken.

Über die Autorin

Prof. Dr.-Ing. Delphine Reinhardt (Senior Member des Institute of Electrical and Electronics Engineers) leitet an der Georg-August-Universität in Göttingen das Institut für Informatik seit 2023 und die Forschungsgruppe „Computersicherheit und Privatheit“ seit 2018. 2019 wurde sie zu einer der zehn weltweiten „Rising Stars in Networking and Communications“ durch N2Women ernannt und mit dem Johann-Philipp-Reis-Preis für herausragende innovative Veröffentlichungen ausgezeichnet. Außerdem wurde ihre Dissertation über den nutzerkontrollierten Datenschutz bei mobilen Datenerfassungssystemen mehrmals ausgezeichnet. Neben ihrer Forschung engagiert sie sich aktiv bei der GI. Beispielsweise ist sie zurzeit stellvertretende Sprecherin des Fachbereichs Sicherheit, Mitglied der Fachgruppenleitung der GI/ITG-Fachgruppe Kommunikation und Verteilte Systeme sowie Vorstandsmitglied im Beirat der Universitätsprofessor(inn)en.

Im Vergleich mit anderen Anwendungsfeldern bleibt das Thema Privatheit in diesem Kontext generell unerforscht.13 So gibt es zum Beispiel noch sehr wenige Untersuchungen, die die möglichen Privatheitsbedenken der Nutzer*innen in den Fokus nehmen. Zudem fehlt es an Lösungen, die es betroffenen Personen ermöglichen, Informationen zu den über sie gesammelten Daten zu bekommen sowie weitere Kontrolle über die Roboter auszuüben, um ihre Privatheit nach ihren persönlichen Präferenzen schützen zu können. Das beinhaltet das gezielte Löschen von Informationen bei gleichzeitiger Beibehaltung der Funktionsfähigkeit des Roboters. Dabei sollten insbesondere die Nutzer*innen selbst in das Design der Lösungen involviert werden, um sicherzustellen, dass sie später auch gut implementiert werden können. Nur so lassen sich Roboter entwickeln, die ohne Bedenken eingesetzt werden können und somit mehr Akzeptanz bei den Nutzer*innen gewinnen. Und das wiederum ist der Weg hin zu einem Einsatz, bei dem sie für Menschen zu echten Haushaltshilfen, Pflegeassistenten oder sogar Gesprächspartnern werden.

1 Hawton, Annie et al. (2011), The Impact of Social Isolation on the Health Status and Health-related Quality of Life of Older People. In: Quality of Life Research

2www.softbankrobotics.com/emea/en/pepper

3 https://qisdk.softbankrobotics.com/sdk/doc/pepper-sdk/ch4_api/perception/tuto/basic_emotion_tutorial.html

4 Cardiell, Lucas et al. (2021), “A Robot is Watching You”: Humanoid Robots and the Different Impacts on Privacy. In: Masaryk University Journal of Law and Tech

5 Ebd.

6 Syrdal, Dag Sverre et al. (2007), “He Knows when You Are Sleeping” — Privacy and the Personal Robot Companion. In: Proc. Workshop on Human Implications of HRI; Westerlund, Mika (2020), An Ethical Framework for Smart Robots. In: Tech. Innovation Mngt. Rev; Bertolini, Andrea & Aiello, Giuseppe (2018), Robot Companions: A Legal and Ethical Analysis. In: The Info. Society; Kaminski, Margot E. et al. (2016), Averting Robot Eyes, In: Maryland Law Rev

7 Syrdal, Dag Sverre et al. (2007), “He Knows when You Are Sleeping” — Privacy and the Personal Robot Companion. In: Proc. Workshop on Human Implications of HRI

8 Tonkin, Meg et al. (2017), Embodiment, Privacy and Social Robots: May I Remember You?, In: Proc. ICSR

9 Butler, Daniel J. et al. (2015), The Privacy-Utility Tradeoff for Remotely Teleoperated Robots. In: Proc. ACM/IEEE HRI; Krupp, M. M. et al. (2017), A Focus Group Study of Privacy Concerns about Telepresence Robots. In: Proc. IEEE RO-MAN; Reinhardt, D., Khurana, M. & Hernandez Acosta, L. (2021), “I still Need my Privacy”: Exploring the Level of Comfort and Privacy Preferences of German-speaking Older Adults in the Case of Mobile Assistant Robots. In: Pervasive and Mobile Computing (PMC)

10 Rueben, Matthew et al. (2018), Themes and Research Directions in Privacy-Sensitive Robotics. In: Proc. Workshop on Advanced Robotics and Its Social Impacts

11 Caine, K. Šabanović, K. & Carter, M. (2016), The Effect of Monitoring by Cameras and Robots on the Privacy Enhancing Behaviors of Older Adults. In: Proc. ACM/IEEE HRI; de Graaf, Maartje MA, Allouch, Somaya Ben & van Dijk, Jan AGM (2016), Long-Term Evaluation of a Social Robot in Real Homes. In: Interaction Studies

12 von der Pütten, Astrid Marieke, Krämer, Nicole C. & Eimler, Sabrina C. (2011), Living with a Robot Companion: Empirical Study on the Interaction with an Artificial Health Advisor. In: Proc. ACM ICMI

13 Fronemann, Nora, Pollmann, Kathrin & Loh, Wulf (2022), Should my Robot Know what’s best for me? Human-Robot Interaction between User Experience and Ethical Design. In: AI & Society; Felzmann et al. (2019), Robots and Transparency: The Multiple Dimensions of Transparency in the Context of Robot Technologies; Lutz, Christoph & Tamò-Larrieux, Aurelia, The Robot Privacy Paradox: Understanding how Privacy Concerns Shape Intentions to Use Social Robots. In: Human-Machine Com. (2020); Harrington, Erin E. et al. (2021), Perceptions of Socially Assistive Robots: A Pilot Study Exploring Older Adults’ Concerns. In: Current Psychology