Fachartikel

Es dreht sich um uns

Dieses Zitat stammt von Steve Jobs. Der Mitbegründer von Apple tätigte die Aussage 1985, als er für das Magazin Playboy – ja, der Playboy – interviewt wurde. Mit dem Vergleich bezieht er sich auf den Macintosh, einen Nachfolger des Apple Lisa, dem ersten Computer mit einer grafischen Benutzeroberfläche und einer Maus zur Navigation. Heutzutage lösen Computermäuse oder grafische Oberflächen keine euphorische Faszination mehr aus. Wir sind gewohnt, unsere Smartphones, Tablets und Laptops über sie zu steuern. Nun soll es in diesem Beitrag aber um Menschzentrierte KI gehen – und nicht um Jobs, Apple oder gar den Playboy. Warum beginne ich also mit diesem Zitat? Weil es sehr anschaulich darlegt, wie Menschen versuchen, technische Geräte stetig zu verbessern, nutzerfreundlicher und intuitiver zu gestalten – und das ist durchaus auch kritisch zu sehen. Denn eine Vereinfachung der Nutzung kann zu einem geringeren Verständnis der dahinterliegenden Funktionsweise der Technologie führen.

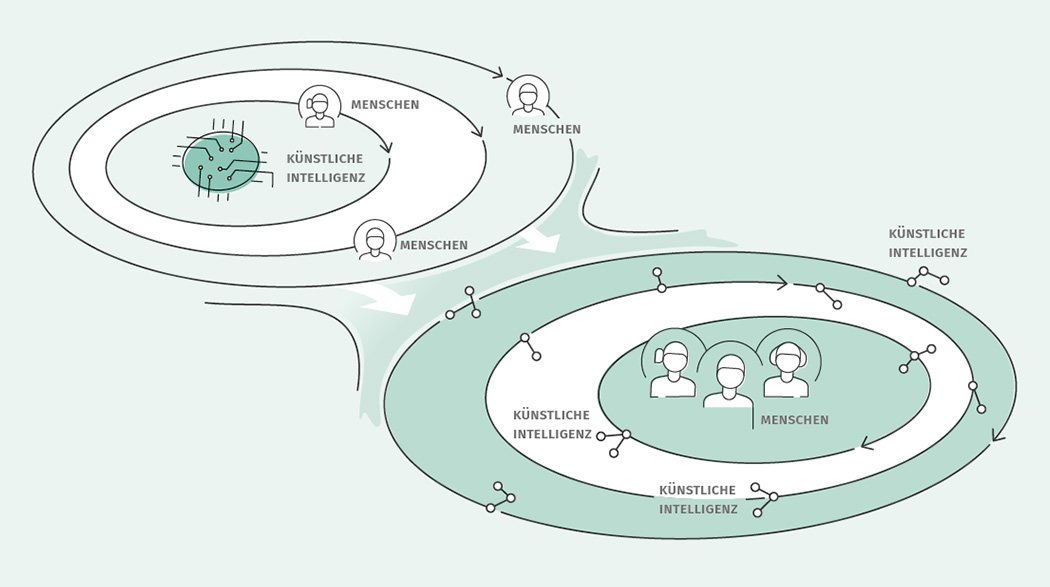

Das zeigt sich besonders eindrücklich beim Thema Künstliche Intelligenz (KI), seit einigen Jahren das Schlagwort schlechthin. Durch sie soll alles besser, schneller, genauer funktionieren. Zumindest versprechen sich das viele Unternehmen, die Kaffeemaschinen mit KI bewerben und intelligente Lichter, Autos, Fernseher oder Waschmaschinen verkaufen. Die Erfolge, die KI-Entwicklungen in den vergangenen Jahren verzeichnen konnten, sind ihnen schwer abzusprechen. Auch viele Forschungsfelder sind auf KI fokussiert, zum Beispiel auf die Erforschung und Weiterentwicklung neuronaler Netze. Dabei rückt mittlerweile ein neuer Begriff in den Fokus: Menschzentrierte Künstliche Intelligenz. Als Forscherin verwende ich gerne Definitionen. Daher möchte ich hier auf Mark O. Riedl1 verweisen, nach dem Menschzentrierte KI eine Perspektive für KI und Maschinelles Lernen einnimmt, die darauf hinweist, „dass Algorithmen in dem Bewusstsein entwickelt werden müssen, dass sie Teil eines größeren Systems sind, das aus Menschen besteht“. Was das konkret heißt, erläutert Riedl so: Menschen müssen in der Lage sein, KI zu verstehen, und KI muss in der Lage sein, Menschen zu verstehen. Ben Shneiderman, Forscher in der Mensch-Computer-Interaktion, bezeichnet die Entwicklung der Menschzentrierten KI sogar als „zweite kopernikanische Revolution“2 (siehe Grafik oben).

Bislang drehte sich alles um die Entwicklung von KI und Menschen mussten sich den dabei entstandenen Systemen anpassen. Menschzentrierte KI kehrt diese Konstellation völlig um. Nun steht nicht mehr die KI-Technologie, sondern der Mensch im Mittelpunkt – und die KI-Systeme sind es, die sich anpassen müssen.

Sicher, verlässlich, vertrauenswürdig

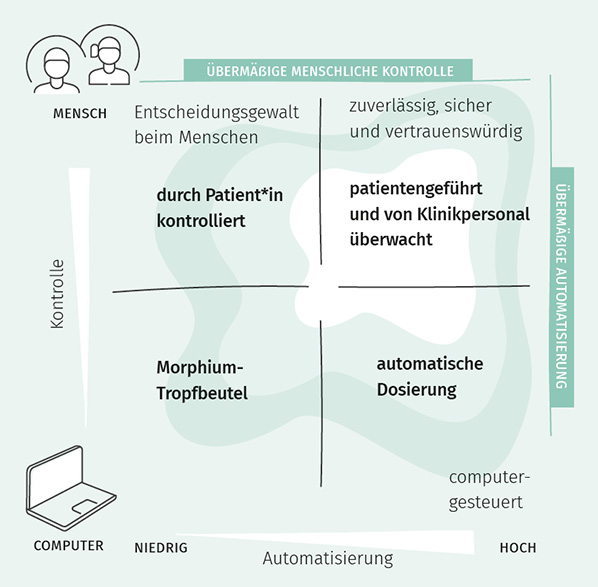

Shneiderman3 illustriert die Idee, dass Menschzentrierte KI drei Voraussetzungen erfüllen muss. Sie sollte reliable, safe und trustworthy (kurz: RST) sein. Hierzu nimmt er zwei Skalen der Betrachtung an: die der menschlichen Kontrolle (wenig Kontrolle vs. viel Kontrolle) und die der Autonomie der Maschine (wenig Autonomie vs. viel Autonomie). Eine Anwendung gilt als RST, wenn eine Maschine über viel Autonomie verfügt, der Mensch aber gleichzeitig die Möglichkeit hat, ein hohes Maß an Kontrolle auszuüben – und beides nicht in ein Extrem verfällt. Als mögliches Beispiel für ein RST-System nennt Shneiderman die Verabreichung von Schmerzmedikamenten. Hier ließe sich in Zukunft mithilfe von KI genau bestimmen, welche Medikamentierung für den Krankheitszustand und die individuellen Daten einer zu behandelnden Person angemessen ist. Die Verabreichung würde dann erfolgen, wenn die Patientin oder der Patient es einfordert. Dabei achtet die KI darauf, eine Überdosierung zu vermeiden. Werden keine Schmerzmittel verabreicht, informiert das System die kranke Person über die Gründe dafür. Zudem könnten medizinische Fachkräfte die KI durch ein Monitoringsystem überwachen.

Verschiedene Konzepte für die Verabreichung von Schmerzmitteln

Explainable AI (XAI)

Erklärbare Künstliche Intelligenz soll es Nutzer*innen ermöglichen, KI-Systeme zu verstehen, ihnen angemessen zu vertrauen und sie effektiv zu verwalten.5

So weit, so gut. Wer in der KI arbeitet, weiß jedoch, dass solche illustrativen Szenarien oft jahrelanger Entwicklung, viel Tüfteln und zahlreichen Herausforderungen gegenüberstehen. Wie also soll eine KI aussehen, die Bedürfnisse, Fähigkeiten und Einschränkungen von Menschen berücksichtigt? Eine pauschale Antwort auf diese Frage gibt es, wie so oft, auch hier nicht. Stattdessen gilt es, den Einzelfall zu untersuchen: Um welche Anwendung handelt es sich? In welchem Kontext wird sie eingesetzt? Und welche Bedürfnisse haben die Menschen, die die Technologie nutzen oder von ihren Entscheidungen betroffen sind? Antworten auf diese letzte Frage bieten Studien, in denen Beteiligte sich die Prozesse, in denen KI eingesetzt wird, anschauen, verschiedene Designs bewerten sowie zukünftige mitgestalten. So lassen sich unterschiedliche Faktoren untersuchen, darunter Fairness, Transparenz, Sicherheit, Privatsphäre und Nachvollziehbarkeit für eine Vielzahl von Nutzergruppen.

Dabei sind die Anwendungen für KI genauso unterschiedlich wie die Gruppen, die sie nutzen – insbesondere, was Nachvollziehbarkeit angeht. Ein Beispiel: Stellen wir uns eine KI-Anwendung vor, die Menschen erklären soll, warum sie bestimmte Entscheidungen getroffen hat. Wird sie in der Bildung eingesetzt, um die Funktionsweise von neuronalen Netzen zu erläutern, hat sie andere Anforderungen und Ziele als eine Anwendung, die als entscheidungsunterstützendes System im medizinischen Kontext genutzt wird. Und auch Nutzer*innen in diesen Szenarien haben andere Vorstellungen und Erwartungen: Während ein Pädagoge zum Beispiel vermitteln möchte, wie das neuronale Netz funktioniert, möchte eine Medizinerin eher wissen, warum ein neuronales Netz auf eine bestimmte Entscheidung gekommen ist, die zum Beispiel der eigenen Diagnose widerspricht.

Nachvollziehbarkeit soll die sogenannte Explainable AI – kurz XAI – gewährleisten. Sie ist kein neues Forschungsfeld, sondern beschäftigte schon die Entwickler*innen von regelbasierten Systemen in den 1970er-Jahren. Heutzutage kommt XAI eine bedeutende Rolle beim Einsatz von tiefen neuronalen Netzen zu. Diese werden aufgrund ihrer mangelhaften Nachvollziehbarkeit und Intransparenz als „Black Boxes“ bezeichnet.

von Links nach rechts Originale Röntgenaufnahme, LRP, LIME und Counterfactual

Layer-wise Relevance Propagation

LRP ist ein modellspezifischer Ansatz, den Bach und Kollegen6 insbesondere für tiefe neuronale Netze entwickelt haben. Hier wird jedem Neuron in einem neuronalen Netz ein Relevanzwert zugewiesen, der misst, wie relevant dieses Neuron für eine bestimmte Vorhersage war. Am Ende erhält man, wie hier zu sehen, eine sehr feingranulare Hervorhebung aller Pixel, die relevant für die Klassifikation waren.

Local Interpretable Model-Agnostic Explanation

LIME7 kann im Gegensatz zu LRP nicht nur für neuronale Netze, sondern auch für andere maschinelle Lernverfahren verwendet werden. LIME hebt sogenannte Superpixel (größere Bereiche im Bild) hervor. Zur Generierung dieser Superpixel können verschiedene Segmentierungsalgorithmen verwendet werden. Abhängig vom gewählten Algorithmus sehen auch die Superpixel unterschiedlich aus und können somit das Ergebnis (Welche Superpixel sind relevant für die Klassifikation?) verändern.8

Counterfactual

Während Ansätze wie LIME und LRP versuchen zu ermitteln, welche Merkmale für die Klassifikation am wichtigsten waren, gibt es auch Algorithmen, die versuchen, die Frage zu beantworten: „Wie müsste ich meine Eingabe ändern, damit ich ein anderes Ergebnis erhalte?“ Diese Art von Erklärungen werden als kontrafaktische Erklärungen9 bezeichnet. Sie beschreiben eine alternative Realität, die im Gegensatz zur beobachteten Realität steht. Wir sehen in der Abbildung eine gesunde Lunge, die sich durch klare Lungenflügel auszeichnet. Hierdurch wird klar, was das neuronale Netz sucht, um Lungenentzündungen zu klassifizieren: die Präsenz einer milchigen Eintrübung.

Diagnose: nachvollziehbar

Eine konkrete XAI-Anwendung habe ich zusammen mit meinen Kolleg*innen am Lehrstuhl für Menschzentrierte Künstliche Intelligenz an der Universität Augsburg 2022 untersucht: Wir trainierten ein CNN (Convolutional Neural Network – eine Untergruppe tiefer neuronaler Netze), das Röntgenbilder als „Lungenentzündung“ oder „Keine Lungenentzündung“ klassifizierte.9 Um seine Entscheidungen nachvollziehen zu können, generierten wir visuelle Erklärungen und setzten dabei drei verschiedene XAI-Methoden ein (siehe Abbildungen). Anschließend erörterten wir in einer Studie, welche dieser visuellen Erklärungen Nutzer*innen halfen, die Klassifikationen der KI korrekt vorherzusagen. Als besonders hilfreich erwies sich dabei die Counterfactual-Methode. Diese Darstellungen führten nicht nur zu besseren Vorhersagen der Nutzer*innen über das neuronale Netz, die Teilnehmenden fühlten sich auch sicherer bei ihrer Vorhersage und waren in der Lage, die für die Entscheidungen relevanten Merkmale korrekt zu benennen. Zudem zeigte sich, dass Teilnehmende entspannter und weniger verärgert waren, wenn sie Counterfactuals betrachteten.

Forschende wie Chromik und Butz4 weisen darauf hin, dass sich Gesellschaft und Politik über die Rolle von (erklärbarer) KI Gedanken machen müssen: Wie soll die Interaktion zwischen Mensch und KI gestaltet sein? Neben der Frage der Interaktion stellt sich auch jene, wie wir KI nutzen wollen: als Partnerin oder als Werkzeug? Forschende wie Shneiderman2 vertreten die Ansicht, dass Computer keine Menschen sind – und Menschen keine Computer. Daraus erschließt sich für ihn, dass man KI auch nicht als solche gestalten sollte, sich also stärker auf ihren Mehrwert als Werkzeug fokussieren sollte, anstatt sie zum Teammitglied oder zur Partnerin zu machen. Stattdessen plädiert er dafür, den Fokus auf die Gestaltung guter Schnittstellen für Menschzentrierte KI zu legen, damit Nutzer*innen mit den KI-Systemen der Zukunft erfolgreich umgehen können, ohne die Kontrolle abzugeben. Ich stimme den Gedanken von Shneiderman zu, würde mit Blick auf die breiten Anwendungsfelder für KI-Technologie noch einen weiteren Punkt einwerfen – und empfehlen: Schaut euch an, für welche Aufgabe und für welche Zielgruppe ihr KI-Systeme entwickeln wollt, und bezieht die Menschen mit ein, die sie nutzen sollen. Nur so werden KI-Systeme in Zukunft so intuitiv – und dabei nachvollziehbar – zu verwenden sein wie heutzutage die Benutzeroberflächen auf PC, Smartphone und Tablet.

Über die Autorin

Katharina Weitz studierte Informatik und Psychologie an der Universität Bamberg. Seit Oktober 2018 arbeitet sie als wissenschaftliche Mitarbeiterin am Lehrstuhl für Menschzentrierte Künstliche Intelligenz der Universität Augsburg. Hier forscht sie an Möglichkeiten, Künstliche Intelligenz für Menschen nachvollziehbar zu gestalten. Damit die gewonnenen Forschungserkenntnisse eine breite Öffentlichkeit erreichen, vermittelt sie in Science Slams, Vorträgen, Workshops und Büchern anschaulich grundlegendes Wissen über Informatik und KI an Jung und Alt. Für dieses Engagement wurde sie 2020 mit dem Junior-Fellowship der GI ausgezeichnet. Derzeit ist sie im Vorstand der GI tätig.

1 Riedl, M. O. (2019). Human-centered artificial intelligence and machine learning. Human Behavior and Emerging Technologies, 1(1), 33-36.

2 Shneiderman, B. (2020). Human-centered artificial intelligence: Three fresh ideas. AIS Transactions on Human-Computer Interaction, 12(3), 109-124.

3 Shneiderman, B. (2020). Human-centered artificial intelligence: Reliable, safe & trustworthy. International Journal of Human–Computer Interaction, 36(6), 495-504.

4 Chromik, M., & Butz, A. (2021). Human-XAI interaction: a review and design principles for explanation user interfaces. In IFIP Conference on Human-Computer Interaction (pp. 619-640). Springer, Cham.

5 Gunning, D., & Aha, D. (2019). DARPA’s explainable artificial intelligence (XAI) program.

AI magazine, 40(2), 44-58.

6 Bach, S., Binder, A., Montavon, G., Klauschen, F., Müller, K. R., & Samek, W. (2015). On pixel-wise explanations for non-linear classifier decisions by layer-wise relevance propagation. PloS one, 10(7), e0130140.

7 Ribeiro, M. T., Singh, S., & Guestrin, C. (2016, August). „Why should i trust you?“ Explaining the predictions of any classifier. In Proceedings of the 22nd ACM SIGKDD international conference on knowledge discovery and data mining (pp. 1135-1144).

8 Schallner, L., Rabold, J., Scholz, O., & Schmid, U. (2020), Effect of superpixel aggregation on explanations in LIME – A case study with biological data. In: Machine Learning and Knowledge Discovery in Databases: International Workshops of ECML PKDD 2019, Würzburg, Germany, September 16–20, 2019, Proceedings, Part I, S. 147–158.

9 Mertes, S., Huber, T., Weitz, K., Heimerl, A., & André, E. (2022). GANterfactual—Counterfactual Explanations for Medical Non-experts Using Generative Adversarial Learning. Frontiers in artificial intelligence, 5.